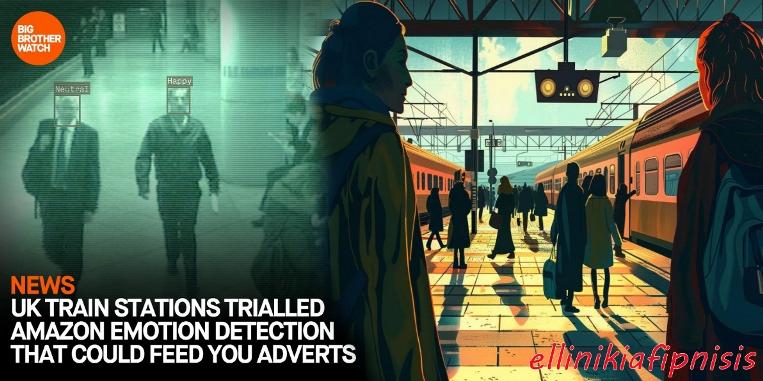

Σάλος με το λογισμικό τεχνητής νοημοσύνης που διαβάζει τη διάθεση των ανθρώπων στους σιδηροδρομικούς σταθμούς της Βρετανίας

Χιλιάδες άνθρωποι που χρησιμοποιούν τρένα στο Ηνωμένο Βασίλειο πιθανότατα είχαν υποστεί σάρωση των προσώπων τους από το λογισμικό της Amazon στο πλαίσιο εκτεταμένων δοκιμών τεχνητής νοημοσύνης, σύμφωνα με αποκαλυπτικά έγγραφα που ήρθαν στη δημοσιότητα…! Υπάρχει κάτι αντίστοιχο στην Ελλάδα άραγε…;

Οι κάμερες κλειστού κυκλώματος τηλεόρασης και η τεχνητή νοημοσύνη συνδυάζονται για την παρακολούθηση του πλήθους, τον εντοπισμό κλοπών ποδηλάτων και τον εντοπισμό παραβατών, σύμφωνα με το επίσημο αφήγημα. Όλα αυτά ωστόσο γίνονται εν αγνοία των επιβατών…

Πηγές: wired.com & Reclaim The Net

Απόδοση: Ελλήνων Αφύπνιση

Στο Ηνωμένο Βασίλειο, μια σειρά δοκιμών τεχνητής νοημοσύνης στις οποίες συμμετείχαν χιλιάδες επιβάτες τρένων που υποβλήθηκαν άθελά τους σε σάρωση από λογισμικό ανίχνευσης συναισθημάτων εγείρει σοβαρές ανησυχίες για την προστασία της ιδιωτικής ζωής. Η τεχνολογία, που αναπτύχθηκε από την Amazon και χρησιμοποιήθηκε σε διάφορους μεγάλους σιδηροδρομικούς σταθμούς, συμπεριλαμβανομένων των Euston και Waterloo του Λονδίνου, καθώς και του Manchester Piccadilly, χρησιμοποίησε τεχνητή νοημοσύνη για να σαρώσει πρόσωπα και να αξιολογήσει τις συναισθηματικές καταστάσεις μαζί με την ηλικία και το φύλο. Έγγραφα (εδώ) που αποκτήθηκαν από την ομάδα πολιτικών ελευθεριών Big Brother Watch μέσω ενός αιτήματος για την ελευθερία της πληροφόρησης αποκάλυψαν αυτές τις πρακτικές, οι οποίες ενδέχεται να επηρεάσουν σύντομα τις διαφημιστικές στρατηγικές.

Τα τελευταία δύο χρόνια, αυτές οι δοκιμές, τις οποίες διαχειρίζεται η Network Rail, εφάρμοσαν «έξυπνη» τεχνολογία CCTV και παλαιότερες κάμερες συνδεδεμένες με συστήματα που βασίζονται σε cloud για την παρακολούθηση μιας σειράς δραστηριοτήτων. Αυτά περιελάμβαναν τον εντοπισμό παραβίασης των γραμμών του τρένου, τη διαχείριση του πλήθους στις πλατφόρμες και τον εντοπισμό αντικοινωνικών συμπεριφορών όπως οι φωνές ή το κάπνισμα. Οι δοκιμές παρακολούθησαν ακόμη και πιθανή κλοπή ποδηλάτου και άλλα περιστατικά που σχετίζονται με την ασφάλεια.

Τα δεδομένα που προέρχονται από αυτά τα συστήματα θα μπορούσαν να χρησιμοποιηθούν για την ενίσχυση των διαφημιστικών εσόδων μετρώντας την ικανοποίηση των επιβατών μέσω της συναισθηματικής τους κατάστασης, που αποτυπώνεται όταν τα άτομα διέσχιζαν εικονικά συρματόσχοινα κοντά σε εμπόδια εισιτηρίων. Παρά την εκτεταμένη χρήση αυτών των τεχνολογιών, η αποτελεσματικότητα και οι ηθικές συνέπειες της αναγνώρισης συναισθημάτων συζητούνται έντονα. Οι επικριτές, συμπεριλαμβανομένων ερευνητών τεχνητής νοημοσύνης, υποστηρίζουν ότι η τεχνολογία είναι αναξιόπιστη και έχουν ζητήσει την απαγόρευσή της, υποστηριζόμενη από προειδοποιήσεις από τη ρυθμιστική αρχή δεδομένων του Ηνωμένου Βασιλείου, το Γραφείο Επιτρόπου Πληροφοριών, σχετικά με την ανωριμότητα των τεχνολογιών ανάλυσης συναισθημάτων.

Το εύρος των δοκιμών τεχνητής νοημοσύνης, στοιχεία των οποίων έχουν αναφερθεί προηγουμένως, αποκαλύφθηκε σε μια κρύπτη εγγράφων που ελήφθησαν ως απάντηση σε αίτημα ελευθερίας πληροφοριών από την ομάδα πολιτικών ελευθεριών Big Brother Watch. «Η ανάπτυξη και η ομαλοποίηση της επιτήρησης τεχνητής νοημοσύνης σε αυτούς τους δημόσιους χώρους, χωρίς πολλές διαβουλεύσεις και συνομιλίες, είναι ένα αρκετά ανησυχητικό βήμα», λέει ο Τζέικ Χάρφουρτ, επικεφαλής έρευνας και ερευνών στην ομάδα.

Οι δοκιμές τεχνητής νοημοσύνης χρησιμοποίησαν έναν συνδυασμό «έξυπνων» καμερών CCTV που μπορούν να ανιχνεύσουν αντικείμενα ή κινήσεις από εικόνες που τραβούν και παλαιότερες κάμερες που έχουν τις ροές βίντεο τους συνδεδεμένες με ανάλυση που βασίζεται σε «σύννεφο». Σε κάθε σταθμό υπήρχαν πέντε έως επτά κάμερες ή αισθητήρες, σύμφωνα με τα έγγραφα, τα οποία χρονολογούνται από τον Απρίλιο του 2023. Ένα υπολογιστικό φύλλο αναφέρει 50 πιθανές περιπτώσεις χρήσης τεχνητής νοημοσύνης, αν και δεν φαίνεται να έχουν χρησιμοποιηθεί όλες στις δοκιμές. Ένας σταθμός, το London Euston, επρόκειτο να δοκιμάσει ένα σύστημα ανίχνευσης «κινδύνου αυτοκτονίας», αλλά τα έγγραφα αναφέρουν ότι η κάμερα απέτυχε και το προσωπικό δεν είδε την ανάγκη να την αντικαταστήσει επειδή ο σταθμός ήταν σταθμός «τερματικός».

Σύμφωνα με το Wired, ο Γκρέγκορι Μπάτλερ, Διευθύνων Σύμβουλος της Purple Transform, ανέφερε τη διακοπή της δυνατότητας ανίχνευσης συναισθημάτων κατά τη διάρκεια των δοκιμών και επιβεβαίωσε ότι δεν αποθηκεύτηκαν εικόνες ενώ το σύστημα ήταν ενεργό. Εν τω μεταξύ, η Network Rail υποστήριξε ότι οι προσπάθειες επιτήρησής της είναι σύμφωνες με τα νομικά πρότυπα και είναι ζωτικής σημασίας για τη διατήρηση της ασφάλειας σε όλο το σιδηροδρομικό δίκτυο. Ωστόσο, τα έγγραφα υποδηλώνουν ότι η ακρίβεια και η εφαρμογή της ανάλυσης συναισθημάτων σε πραγματικές συνθήκες παραμένουν αναξιόπιστες, όπως σημειώνεται σε αρκετές αναφορές από τους σταθμούς.

⚠️We’ve uncovered documents revealing that eight train stations trialled Amazon’s AI surveillance software with their CCTV cameras – with some analysing passengers’s age, gender and emotions

“The rollout and normalisation of AI surveillance in these public spaces, without much… pic.twitter.com/dJLS75ZURH

— Big Brother Watch (@BigBrotherWatch) June 17, 2024

Οι υποστηρικτές της ιδιωτικής ζωής ανησυχούν ιδιαίτερα από την αδιαφανή φύση και την πιθανότητα υπέρβασης στη χρήση της τεχνητής νοημοσύνης σε δημόσιους χώρους. Ο Jake Hurfurt από το Big Brother Watch έχει εκφράσει σημαντικές ανησυχίες για την ομαλοποίηση μιας τέτοιας επεμβατικής επιτήρησης χωρίς επαρκή δημόσιο διάλογο ή επίβλεψη. Λέει ότι το πιο «ανησυχητικό» στοιχείο των δοκιμών επικεντρώθηκε στα «δημογραφικά στοιχεία των επιβατών». Σύμφωνα με τα έγγραφα, αυτή η ρύθμιση θα μπορούσε να χρησιμοποιήσει εικόνες από τις κάμερες για να παράγει μια «στατιστική ανάλυση του εύρους ηλικιών και των δημογραφικών στοιχείων ανδρών/γυναικών», και είναι επίσης σε θέση να «αναλύσει συναισθήματα» όπως «χαρούμενος, λυπημένος και θυμωμένος».

Οι εικόνες καταγράφηκαν όταν οι άνθρωποι διέσχισαν ένα «εικονικό καλώδιο ταξιδιού» κοντά σε εμπόδια εισιτηρίων και στάλθηκαν για ανάλυση από το σύστημα αναγνώρισης της Amazon, το οποίο επιτρέπει την ανάλυση προσώπου και αντικειμένων. Θα μπορούσε να επιτρέψει τη μέτρηση της «ικανοποίησης» των επιβατών, αναφέρουν τα έγγραφα, σημειώνοντας ότι «αυτά τα δεδομένα θα μπορούσαν να χρησιμοποιηθούν για το μέγιστο των διαφημιστικών και λιανικών εσόδων».

Ο Τζέικ Χάρφουρτ, Επικεφαλής Έρευνας και Έρευνας στο Big Brother Watch, δήλωσε επίσης: «Η Network Rail δεν είχε το δικαίωμα να αναπτύξει απαξιωμένη τεχνολογία αναγνώρισης συναισθημάτων ενάντια σε αθέλητους μετακινούμενους σε μερικούς από τους μεγαλύτερους σταθμούς της Βρετανίας και έχω υποβάλει μια καταγγελία στον Επίτροπο Πληροφοριών για αυτήν τη δοκιμή.

«Είναι ανησυχητικό το γεγονός ότι ως δημόσιος φορέας αποφάσισε να πραγματοποιήσει μια μεγάλης κλίμακας δοκιμή παρακολούθησης τεχνητής νοημοσύνης από την Amazon σε αρκετούς σταθμούς χωρίς ενημέρωση του κοινού, ειδικά όταν το Network Rail συνδύασε την τεχνολογία ασφαλείας με ψευδοεπιστημονικά εργαλεία και πρότεινε ότι τα δεδομένα θα μπορούσαν να δοθούν στους διαφημιστές».

«Η τεχνολογία μπορεί να διαδραματίσει ρόλο στην ενίσχυση της ασφάλειας των σιδηροδρόμων, αλλά πρέπει να υπάρξει μια έντονη δημόσια συζήτηση σχετικά με την αναγκαιότητα και την αναλογικότητα των εργαλείων που χρησιμοποιούνται.

«Η επιτήρηση με τεχνητή νοημοσύνη θα μπορούσε να θέσει σε κίνδυνο όλο το απόρρητό μας, ειδικά εάν γίνει κακή χρήση, και η παράβλεψη αυτών των ανησυχιών από την Network Rail δείχνει περιφρόνηση των δικαιωμάτων μας».

https://ellinikiafipnisis.blogspot.com